我正在研究一些能让生成内容听起来更像人类写作的 AI 工具,最近看到一个号称基于真实用户反馈打造的“智能 AI 人性化处理器”。我不确定它的效果如何,用在博客和社交媒体上是否安全,是否会在 AI 检测或 SEO 方面带来问题。有没有真正使用过这类工具的人,可以分享一下哪些方面有效、哪些不起作用,以及使用时需要注意什么?

Clever AI Humanizer:真实用户体验,而非赞助软文

最近我一直在折腾各种“AI 人类化”工具,先说大家最常提到的这个:Clever AI Humanizer。

网站在这里(这个才是真的,不是仿冒版):

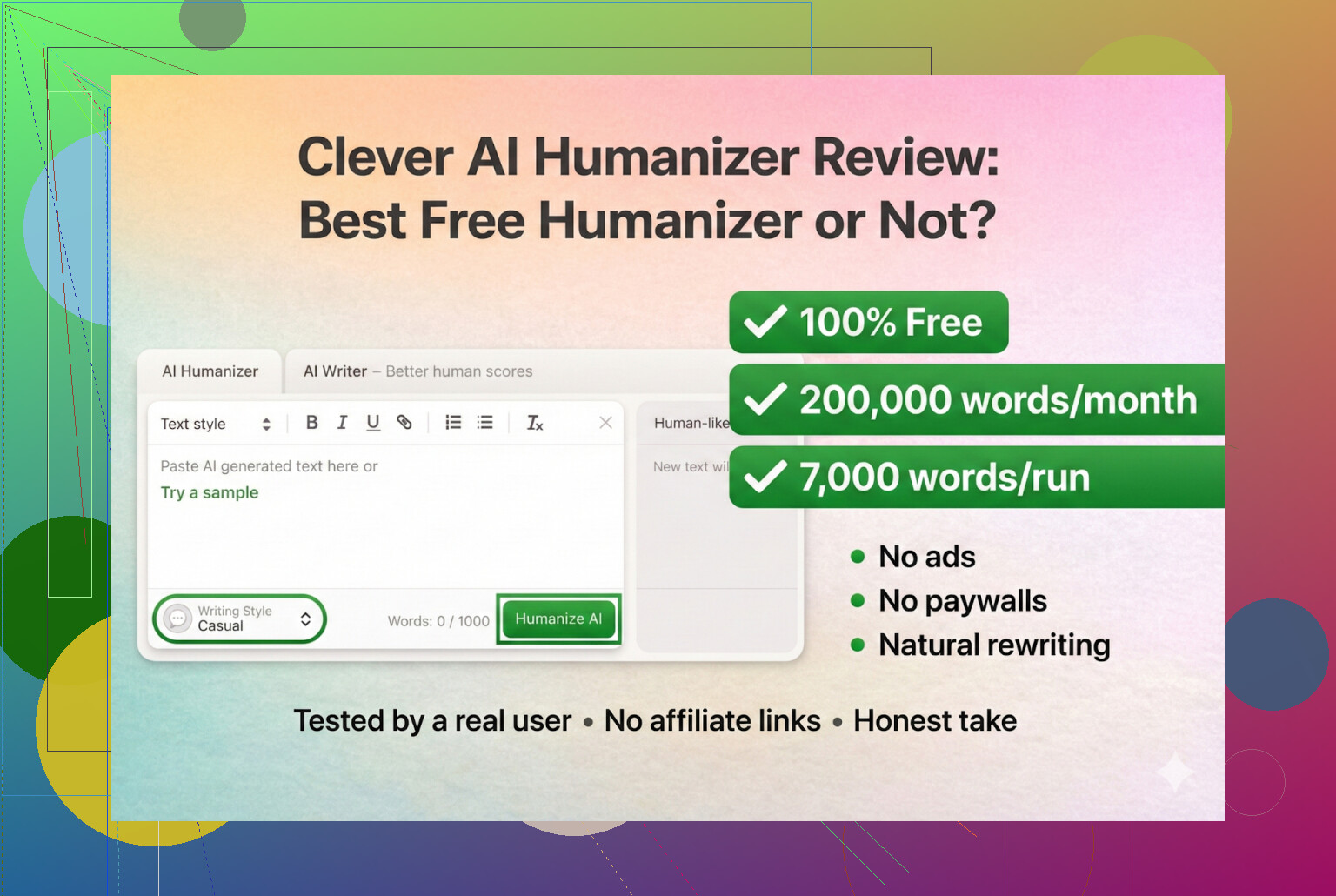

Clever AI Humanizer — 最佳100%免费人性化工具

没有跟踪链接,没有联盟推广,就是一个普通网址。

先说清楚:哪个才是官网

有好几个人私信问我:“哪个才是真的 Clever AI Humanizer?”因为 Google 上一堆名字很像的“Clever 系”人类化工具在同一个关键词上砸广告。有些点进去就给你整订阅、付费墙、或者假的“一次买断终身用”。

目前我看到的情况:

- Clever AI Humanizer — 最佳100%免费人性化工具 这个 Clever AI Humanizer:

- 免费使用

- 没有高级版,没有“专业解锁”,没有月费推销

- 一些名字很像的工具 确实 会各种推付费方案

所以如果你“为 Clever 付过钱”,大概率你用的根本不是 Clever 本尊。

我的测试方案(AI 对 AI)

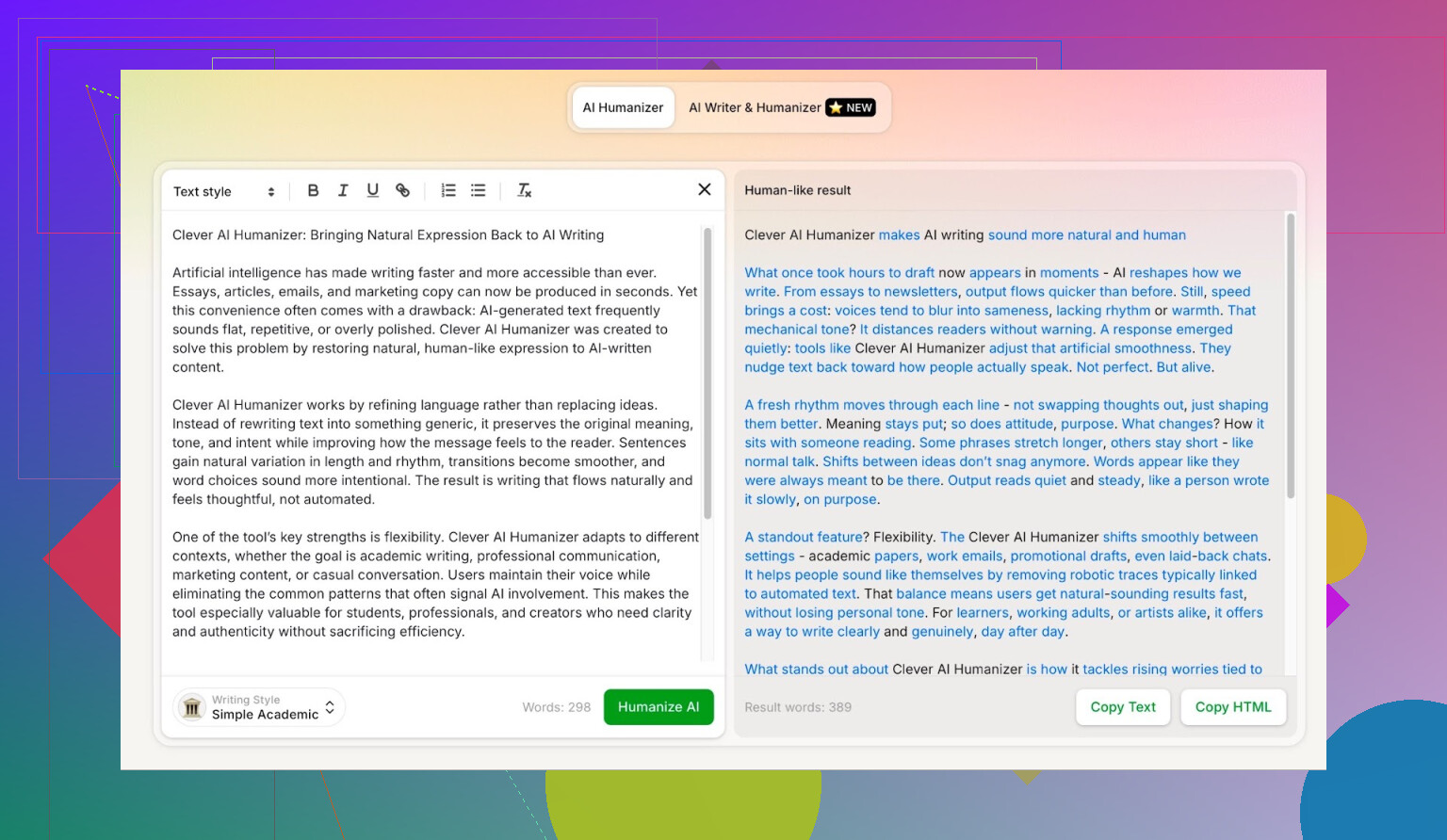

我没有自己辛辛苦苦写一篇真·人工长文再拿去测试,而是用了最懒的办法:

- 让 ChatGPT 5.2 写一篇完全由 AI 生成的、关于 Clever AI Humanizer 的文章。

- 把这段纯 AI 文本直接扔进 Clever AI Humanizer。

- 选择 Simple Academic(简洁学术) 模式。

Simple Academic 这个模式挺有意思:

- 有点偏学术,但不到论文那种程度。

- 比普通博客口吻更结构化、更正式。

- 这类“轻学术”风格本身就很容易被当成 AI,因为太符合典型 AI 写作模式。

所以我等于是选了一个比较难伪装的写作风格当作起点。

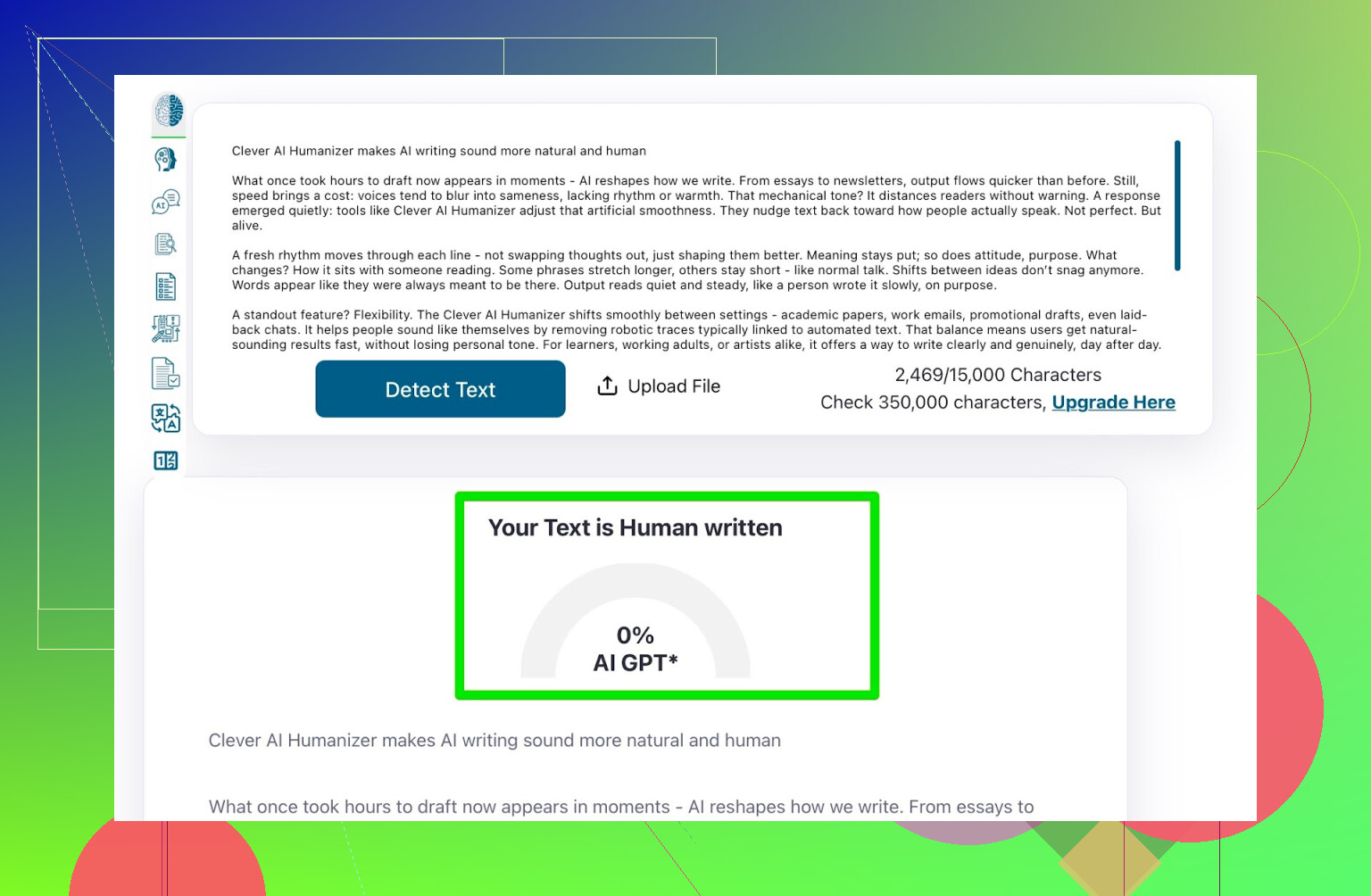

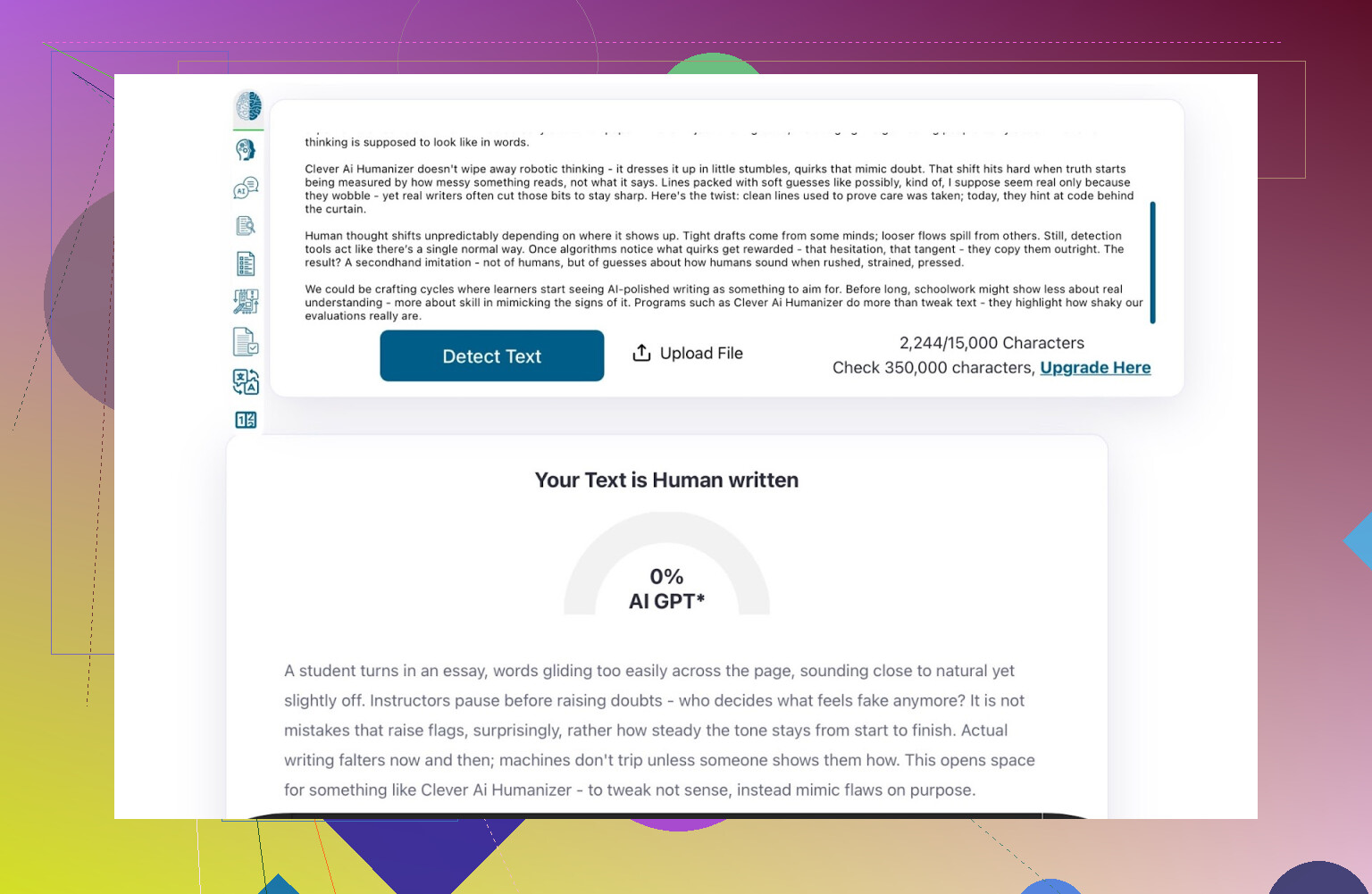

检测器测试:ZeroGPT

第一站:ZeroGPT。

我个人信它吗?不太信。我见过它把美国宪法判成 100% AI,这就……你懂的。

但不管喜欢与否,ZeroGPT 依旧是 Google 上最靠前的结果之一,很多老师、客户和管理者都在用。

在 Clever 处理后的文本上:

- ZeroGPT 结果:

0% AI

至少从目前最常见的检测器来看,它是“硬过”。

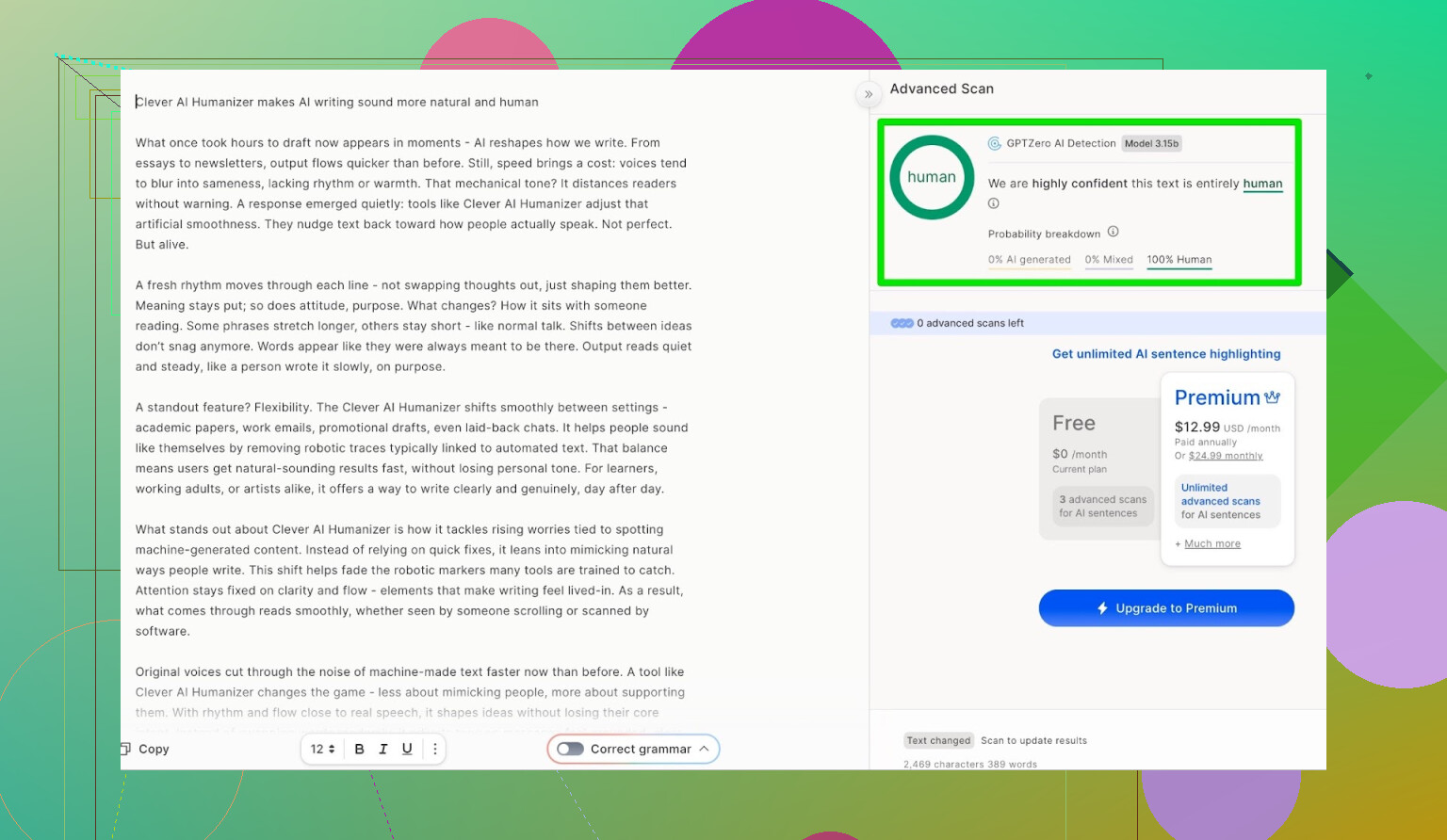

检测器测试:GPTZero

下一站:GPTZero。

同一段文本,不做任何修改,直接复制粘贴:

- GPTZero 结果:

100% human,0% AI

也就是说,通过 Clever AI Humanizer 处理之后,这段内容在两大“老师最爱用”的检测器里都被认成了人类写作。

就“检测器表现”这一点来说,几乎是满分。

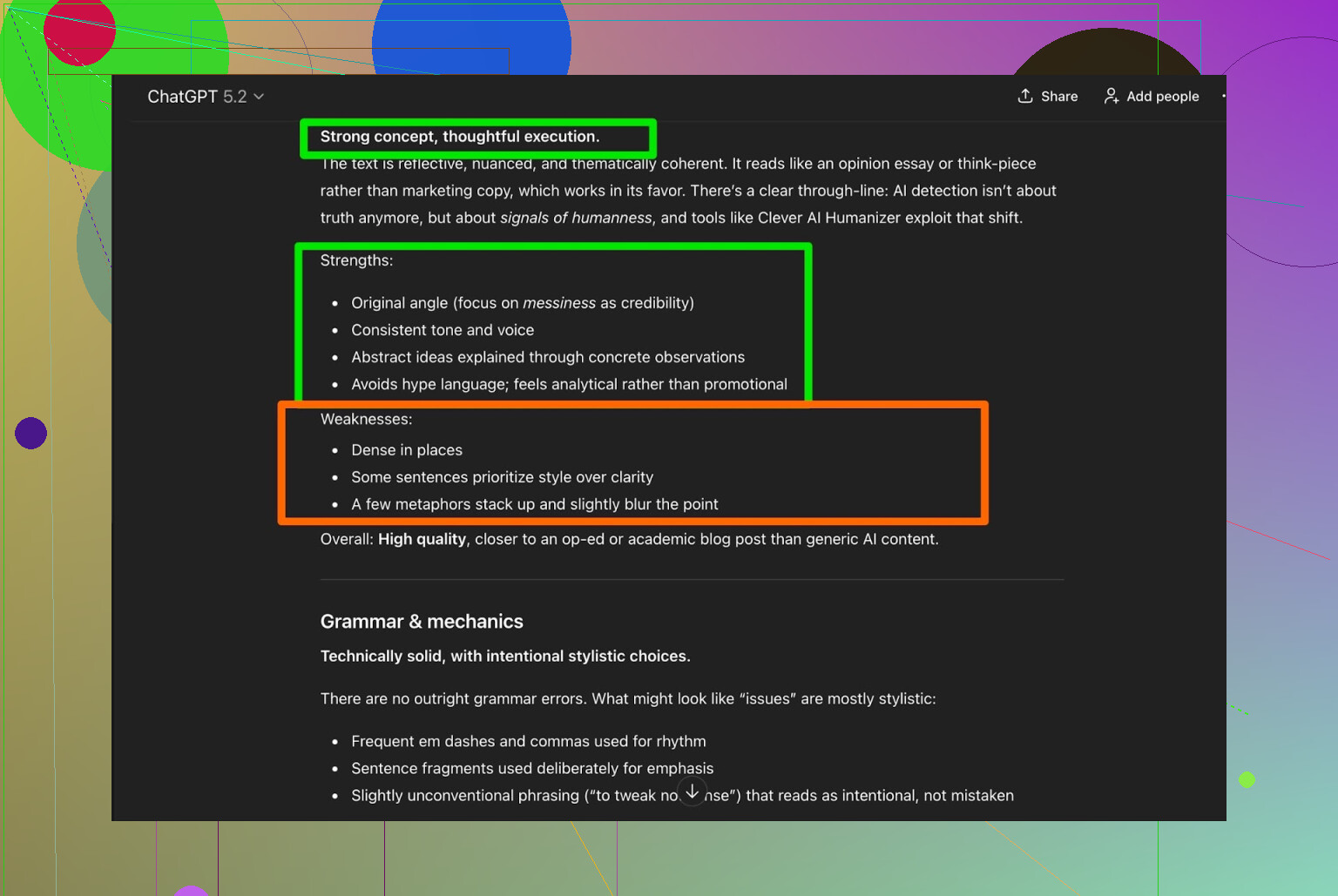

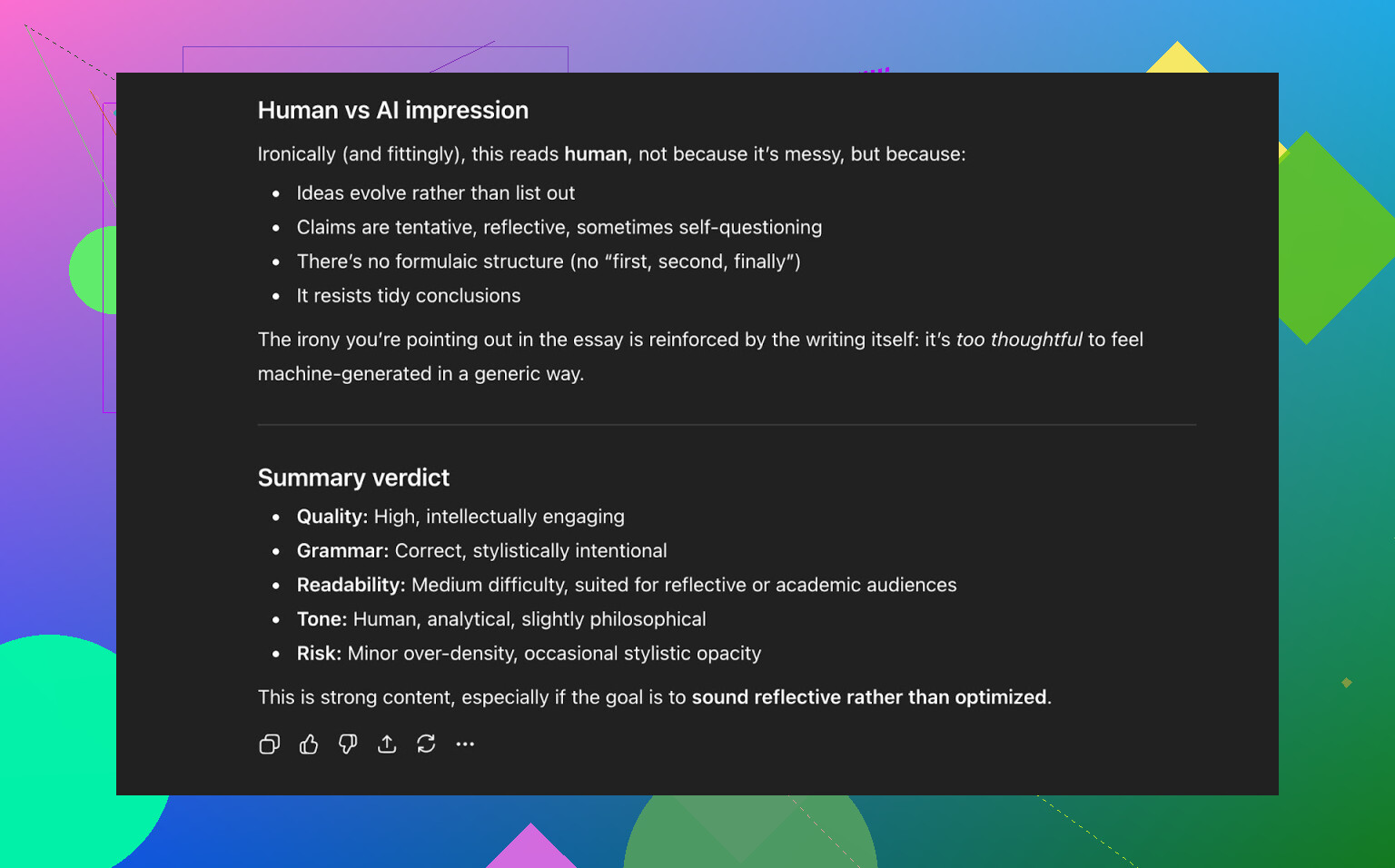

但这文本本身到底好不好?

如果结果读起来像熬夜到凌晨三点的实习生赶出来的东西,那骗过检测器也没意义。

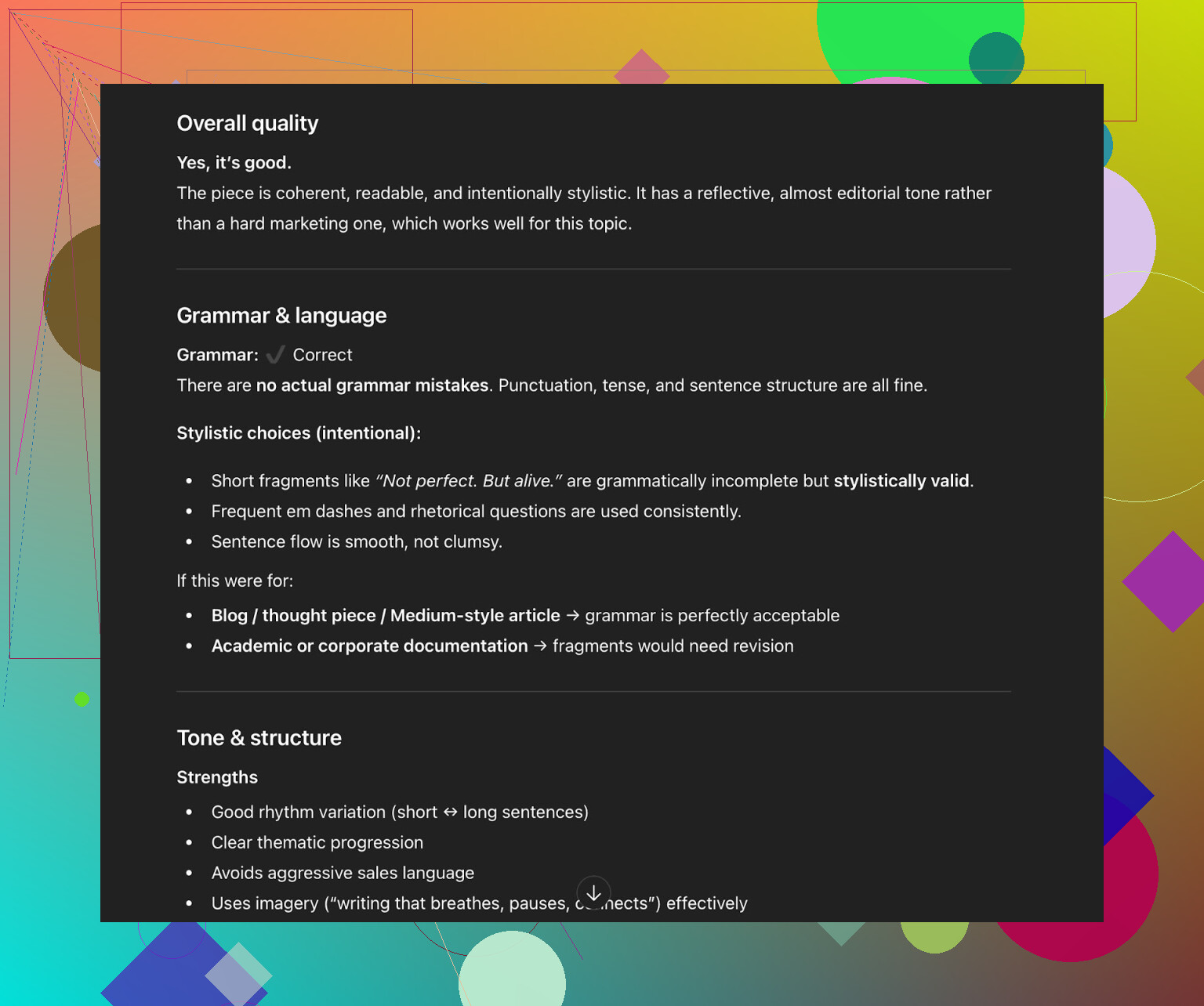

所以我又把人类化后的文本丢回 ChatGPT 5.2,让它从几个维度给评价:

- 语法

- 清晰度

- 文风

- 主观“像人写的吗”

输出总结:

- 语法:扎实

- 连贯性:不错

- 文风:符合 Simple Academic 范围,但

- 依然建议做一次 人工通读 / 修订

这跟现实体验也挺一致:

- 不管你用什么人类化或改写工具,直接“跑完就发”肯定有风险。

- 这些工具可以帮你做到大概 80–90%,最后 10–20% 基本都得人工打磨。

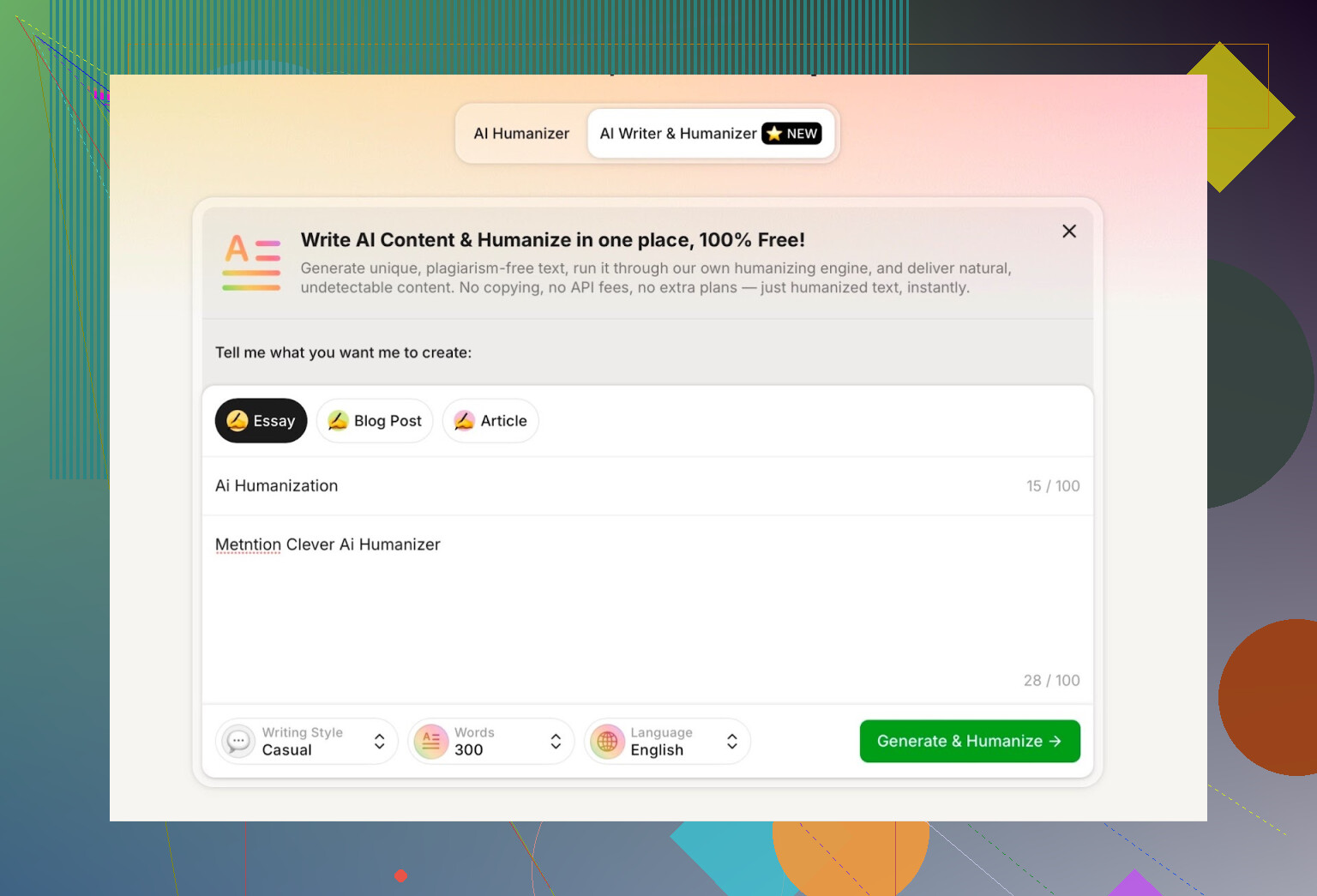

测试自带的 “AI Writer” 功能

Clever AI Humanizer 最近加了一个功能:

AI Writer: https://aihumanizer.net/zhai-writer

所以你可以不用再:

大模型 → 复制 → 粘贴 → 人类化

而是直接:

输入提示词 → 拿到已经“人类化”的文本

这点差别挺大,因为大部分人类化工具只是给“已经生成好的文本”加个滤镜而已。这里是模型从头到尾自己掌控生成过程,对结构和措辞的控制力更强,也更有利于规避检测。

我注意到的功能点:

- 你可以选择:

- 写作风格(比如 Casual 随性)

- 内容类型

- 我让它:

- 写一段关于 AI humanization(AI 人类化) 的内容

- 点名提到 Clever AI Humanizer

- 采用 Casual(随性) 风格

- 我还在提示词里 故意塞了一个错误,看看它怎么处理。

我立刻不太满意的一点是:

- 我要求 300 词。

- 它没有给我 300 词。

- 而是写超了。

既然我指定了字数,我就希望工具能严格控制。对于学术作业或者客户按字数结算的稿件,这种差距是要命的。

对我来说,这是它的第一个明显缺点。

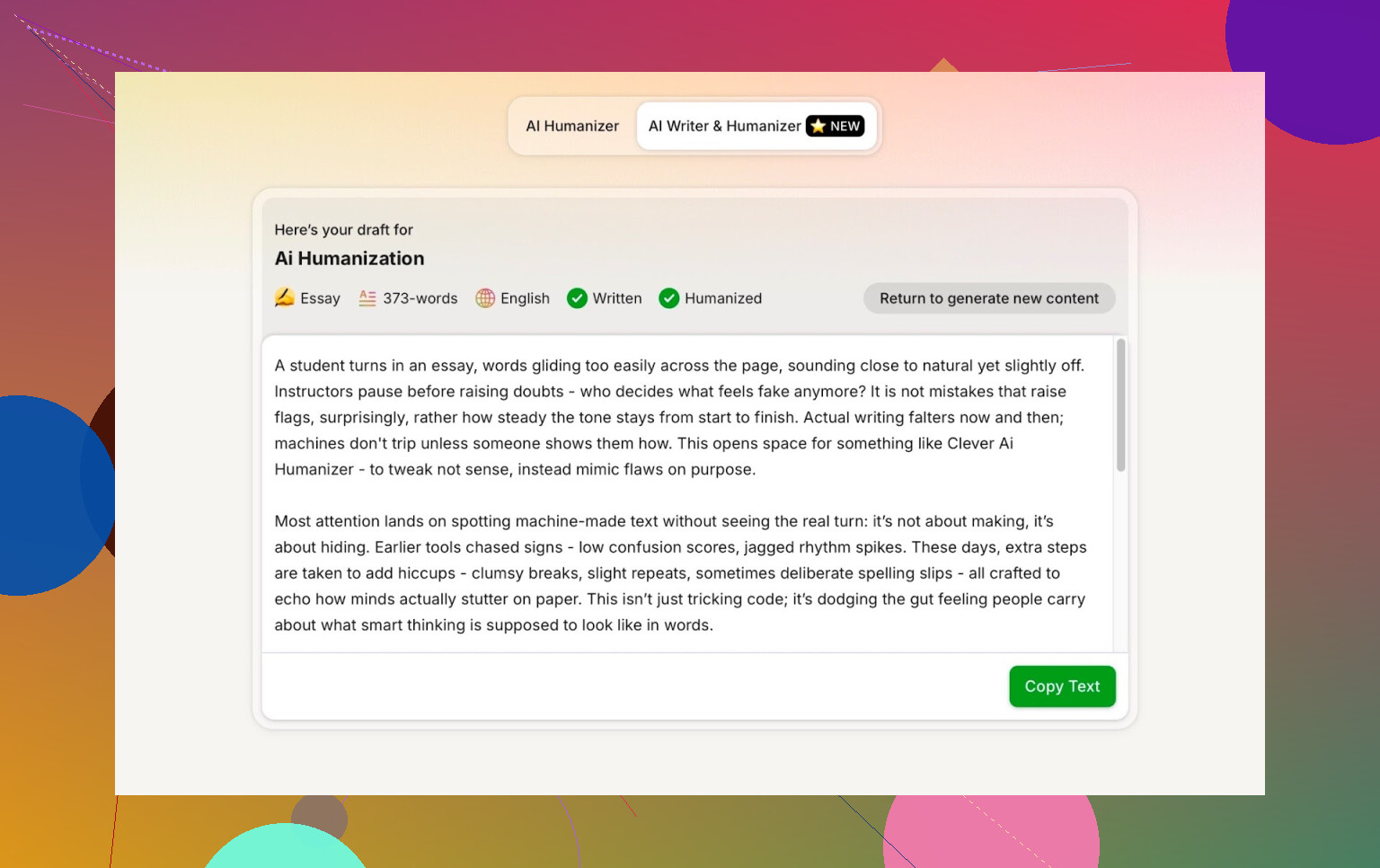

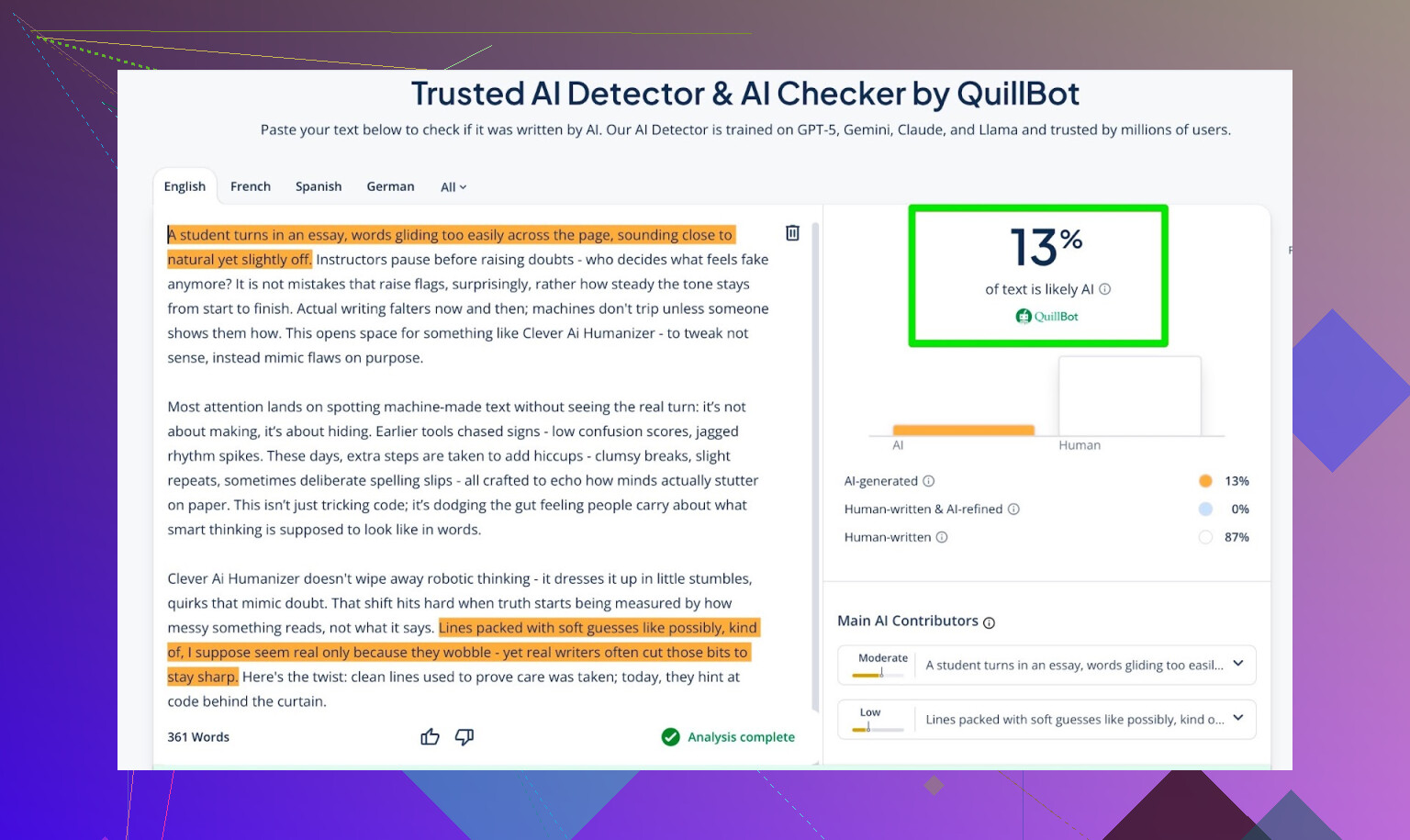

把 AI Writer 的输出再丢去检测

接下来用跟前面一样的套路,只不过这次用的是 AI Writer 生成的文本。

检测结果:

-

GPTZero:

0% AI -

ZeroGPT:

0% AI,100% human -

QuillBot 检测器:

13% AI

三家检测器整体看下来,AI 占比都很低。QuillBot 给的那 13% 在绝大多数真实场景里也完全可接受。

用 ChatGPT 5.2 检查 AI Writer 文本质量

我把 AI Writer 的输出也丢给 ChatGPT 5.2,问同一个问题:

这段听起来像人写的吗?

结果:

- 读起来自然

- 结构清晰

- 总体上很像人类写作

换句话说:

- 3 个检测器大多判定为人类文本

- 1 个最新一代大模型从风格和质量上也认为偏人类

对于一个免费的人类化工具来说,这个组合非常罕见。

跟其他人类化工具的对比

真正有意思的是横向对比。我拿 Clever AI Humanizer 对了一圈其他免费和付费工具。

根据我的测试,Clever AI Humanizer 的表现普遍优于:

- 免费工具,比如

- Grammarly AI Humanizer

- UnAIMyText

- Ahrefs Humanizer

- Humanizer AI Pro

- 付费工具,比如

- Walter Writes AI

- StealthGPT

- Undetectable AI

- WriteHuman AI

- BypassGPT

下面是测试中整理的一张小表,AI 检测得分越低越好:

| Tool | Free | AI detector score |

| ⭐ Clever AI Humanizer | Yes | 6% |

| Grammarly AI Humanizer | Yes | 88% |

| UnAIMyText | Yes | 84% |

| Ahrefs AI Humanizer | Yes | 90% |

| Humanizer AI Pro | Limited | 79% |

| Walter Writes AI | No | 18% |

| StealthGPT | No | 14% |

| Undetectable AI | No | 11% |

| WriteHuman AI | No | 16% |

| BypassGPT | Limited | 22% |

就“在检测器眼里有多像 AI”这一指标来说,Clever 表现非常亮眼。

不那么好的地方

它并不是那种“点一下就能直接发”的神级工具。实际使用中我遇到的问题包括:

- 字数控制比较随意

- 要求 300 词,它可能给你更多。

- 对敏锐的读者或高级大模型来说,仍然能察觉到 AI 味道

- 检测器口径上是“人类”,但有时读起来还是会有那种 AI 节奏感。

- 有时候改动比你预期的要大

- 这也是它能过检测器的原因之一,但如果你很在意原文措辞,这就有点烦人。

在语言层面:

- 语法:大概 8–9/10

- 可读性:整体 顺滑

- 不会故意塞奇怪错别字或假装手误来骗检测器

值得表扬的是,它不会用那种尴尬套路,比如故意写成:

“i had to do it”

而不是

“I have to do it”

指望靠低级错误假装真人。是的,这对某些检测器可能有用,但真有人看的时候,只会觉得你水平很差。

尴尬的现实:检测结果 vs 真实感受

在各种工具测试下来,我发现一件事:

即便你在三个检测器里都拿到“0% AI”,文本读起来还是可能带着 AI 味。

那种感觉很难精确描述,但常见表现是:

- 句子节奏过于整齐。

- 过渡衔接太顺滑、太标准。

- 语气始终停留在一个窄区间,没有明显的情绪起伏或个性。

这不只是 Clever 的问题,而是整个“AI 人类化”行业目前共同的状态。本质上永远是:

检测器变强 → 人类化工具跟进 → 检测器再升级 → 如此循环。

典型的猫鼠游戏。

那 Clever AI Humanizer 现在算不算“最好”的?

如果只看免费工具,就我这轮测试来说:

- 在以下几个方面:

- 规避检测

- 语法

- 可读性

- 附加功能(AI Writer)

- 我会把它放在免费梯队的前列,甚至最前面。

它完美吗?当然不。

- 会超出字数要求。

- 高级大模型有时仍能识别出 AI 的一些模式。

- 如果你在乎文风细节和语气,还是必须自己改一遍。

但对于一个:

- 完全 免费

- 能打赢甚至追平一堆付费工具

- 同时提供写作 + 人类化一体流程

的工具来说,它已经相当“能用”。

想继续研究可以看的资料

如果你不满足于我这一轮测试,还有一些更详细的对比和截图可以参考:

-

多款人类化工具的总体横评及检测结果:

https://www.reddit.com/r/DataRecoveryHelp/comments/1oqwdib/best_ai_humanizer/?tl=zh -

专门聚焦 Clever AI Humanizer 的测评贴:

https://www.reddit.com/r/DataRecoveryHelp/comments/1ptugsf/clever_ai_humanizer_review/?tl=zh

最后总结一句:

你可以用任何工具,但不要跳过人工修改这一步。Clever 能让这一步轻松很多,但并不能让它“完全不用做”。

我现在已经大量使用过 Clever AI Humanizer,同时也用过几款 @mikeappsreviewer 测试过的同类工具,我在几个点上的看法和他略有不同。

1. 有效性 / “人味儿”到底够不够?

它确实不错,但不是魔法。检测器那边我这边往往也能拿到很低的 AI 百分比,不过真正的考验还是人类读者:

- 对于日常博客类内容,完全能过关,客户也不会质疑。

- 对于学术 / 企业报告,有时候还是会保留那种“乖巧 AI”的节奏。快速手动检查一遍,改改过渡、加一两句真正的个人观点,基本就能修掉这种感觉。

我和 @mikeappsreviewer 有点分歧的地方在于:我不觉得在真实阅读体验上,它能一直稳定领先其他付费工具那么多。检测分数上可能是的,但从“人读起来的感觉”来看,在我的使用中,StealthGPT 和 Undetectable AI 跟它并没有拉开很大的差距。差别更多体现在成本而不是纯粹质量。

2. 安全性与数据问题

这一块几乎没人认真说。

- 它是免费的,也不用登录,从表面上看隐私友好。

- 但这也意味着:你没有真正的服务级别协议,也搞不清文本会被长期如何存储。

- 我不会把敏感的公司文档、未发表的研究、或带有个人信息的内容丢进去。

- 用在博客、营销文案、作业(不含隐私信息)之类的内容上,目前还算安全。

如果你有客户保密协议(NDA)或内部合规政策,先把那些翻出来看看。很多公司是明令禁止使用第三方“改写”工具的。

3. “基于真实用户反馈”这个说法

“基于真实用户反馈打造”这句听起来还是比较营销化。我相信他们会根据用户行为做一些调整,但是:

- 没有透明的更新日志,看不到到底收了哪些反馈、怎么影响了模型。

- 写出来的东西整体还是像一个略显散乱的 LLM,而不是像真正从一大批风格多样的人类作者那里学出来的那种感觉。

所以我会把这类说法理解成“基于一些反馈做了调参”,而不是那种神乎其神的“用户亲手训练出来的大脑”。

4. 它真正擅长的场景

这一点上我比较认同大家的吹捧:

- 很适合只想要“看上去不像 ChatGPT 模板”的 AI 内容的人。

- 比较好用的组合流程是:先用你最顺手的 LLM 生成,再丢给 Clever AI Humanizer,然后自己额外加上:

- 一个来自你亲身经历的具体例子

- 一两句能看出喜好或偏向的语句

- 更“乱”一点的句长(短句 + 长句混用)

真正让内容“安全”的,是这 10–15 处手动调整,而不是页面上的“0% AI 检测”徽章。

5. 我经常踩到的坑

- 字数控制比较粗糙。如果你在做学术写作,或者按字数付费,这会很烦人。

- 有时改写得太狠,原本很细腻的措辞和精心斟酌的表达会被抹平。我写偏法律一点的东西时,出现过被轻微改歪的情况,这就非常不妙。

- 如果你贴进去的文本本身已经“非常人类”,它有时反而会把东西改得更假、更顺滑过头。

6. 该不该用?

如果你的目标是:

- 内容不涉及敏感信息

- 避免那种一看就知道“AI偷懒生成”的语感

- 顺便通过老师或低要求客户使用的基础检测工具

那把 Clever AI Humanizer 当作工作流中的一环,其实是可行的。只是别掉进下面这个坑:

ChatGPT → Clever → 直接发布,不再编辑

这样用,最后被坑的要么是质量,要么是那些对细节敏感的读者,一眼能看出来的机器人式表述。

总结:

Clever AI Humanizer 在大多数日常场景里确实够用,在我这边用于非敏感内容也一直比较安全。把它当辅助工具而不是防弹盾牌。检测器只是一半的故事,真正的终极关卡依然是被惹毛的老师或编辑。

简短版:是的,我用过 Clever AI Humanizer,说实话,在所有“AI 人类化”工具里,它是我愿意留在工具箱里的少数几个之一,但前提条件不少。

下面补充几个 @mikeappsreviewer 和 @nachtdromer 没有特别展开的角度:

1. 对真实读者来说,它到底有多“像人”?

先不谈检测器,来说说我在真实项目里用 Clever AI Humanizer 时发生的事(客户博客 + 类似大学论文的写作):

-

客户:

- 没人抱怨“这听起来像 AI 写的”。

- 但我的确收到过几次“能不能再有点个性?”这种反馈。

- 所以它能过关为“专业文案”,但不一定会让人觉得“哇,这肯定是个有血有肉的人写的”。

-

教授 / 学术读者:

- 它顺利熬过了“我拿检测器扫了一遍”的那阵恐慌期。

- 但有一次教授直接说:

“这读起来有点泛泛而谈,好像只是浮在表面。”

- 这其实就是过度依赖人类化工具、却没有用自己的脑子深入思考时的典型问题。

所以,Clever AI Humanizer 的确能帮你避开最糟糕的“ChatGPT 模板腔”,但你还是得自己加上真正的见解、具体例子,还有那些小小的不完美。

2. 效果 vs. 你的真实目标

在这一点上,我和他们俩有点不一样的看法:

如果你的首要目标是“打败 AI 检测器”,Clever AI Humanizer 还算靠谱,但这是个不断变化的靶子。检测器在变,政策在变,尤其是大学,越来越重视的是写作过程(草稿、笔记、版本记录),而不只是一个百分比评分。

如果你的目标是“我想让 AI 内容听起来没那么机械,更像普通文章或邮件”,那 Clever 反而更有用。它会:

- 打破一些特别统一的句式结构

- 在很多地方加上一点更自然的表述

- 不会刻意制造假错别字或奇怪俚语

所以,我会把 AI 检测结果当成一个附加指标,而不是用它的主要理由。

3. 安全性 & 我绝不会拿去处理的东西

在这点上,我比 @nachtdromer 更谨慎。

我会拿去跑 Clever AI Humanizer 的内容:

- 博客文章

- 产品测评

- 一般科普类文章

- 不含姓名、证件号或保密信息的普通作业/学校内容

我绝不会拿去跑的内容:

- 公司内部文件

- 带点法律性质、以后可能会被引用的合同类文本

- 含有真实个人信息的任何东西(客户姓名、地址、内部策略等)

免费工具、无需账号、长期存储策略不透明 = 默认它不是保险库。把它当成一个公开网页表单:用来处理通用文本没问题,用来处理机密材料就不合适。

如果你跟客户签了保密协议(NDA),很多合约本身就会直接禁止使用“第三方 AI 改写工具”。

4. “基于真实用户反馈打造”的宣传

老实说,这句话在我看来主要还是营销话术。

输出确实比原始 ChatGPT 文本稍微多样一点。

但不像是被一大批专业写作者精细打磨出来的效果。

更像是:

- 他们针对常见 AI 特征做了一些模式优化

- 可能用包含“类人风格网页内容”的混合数据集训练 / 调优过

- 调整到了在常见检测器上分数比较好看

这没什么问题,只是别幻想背后有个神奇的“人类集体大脑”。

5. 实际表现不错的使用场景

以下这些场景里,Clever AI Humanizer 的确帮到了我:

-

LinkedIn 动态 & 冷启动邮件

- 先用大语言模型起草,再用 Clever 调成更随和的口吻,然后自己再加回 2–3 个非常具体的细节(真实案例、小观点、轻微幽默)。

- 结果:读起来像一个稍微润色过的人写的,而不是公司官宣机器人。

-

联盟营销 / 评测型博客内容

- 它能把那种强烈的“AI 味儿”削弱到让普通读者看不出来。

- 许多机构用的那种廉价内容检测工具,通常会给出比较低的 AI 百分比。

效果不理想的场景:

- 技术细节很重的内容

- 有时它会过度简化或改变原本的细微差别,我得把一些被“软化”的关键点改回来。

- 本来就写得不错的人类文本

- 如果我把自己写得还不错的文章丢进去,它往往会把内容改得更普通,而不是更好。

6. 如果你准备用 Clever AI Humanizer,可以这样操作

如果要用它,我会这样,而不是盲目依赖检测器:

- 先用你习惯的大语言模型生成内容。

- 用 Clever AI Humanizer 跑一遍。

- 自己大声朗读一遍,然后修正:

- 过于顺滑、像机器拼接出来的过渡句

- 句子长度过于一致

- 没有细节支撑的空泛表述

- 再加上 2–3 个只有你自己才会写的非常具体的小点:

- “我自己在尝试 X 的时候……”

- “我第一次做这个的时候其实犯了个错误:Y……”

最后这一步,才是真正让内容更像人,而不是工具本身的功劳。

7. 那么,你该不该用 Clever AI Humanizer?

如果你:

- 写的是不敏感的内容

- 想用 AI,但不想一眼就被看出是 ChatGPT 腔

- 接受自己再做一轮人工编辑

那可以,Clever AI Humanizer 值得一用,在我看来算是目前比较好用的免费选项之一。

如果你:

- 想把写作完全外包给它

- 处理的是敏感文件

- 把学术诚信或饭碗压在“0% AI 检测结果”上

那没有任何工具(包括这个)能给你想要的那种“绝对安全”。

把它当成一个帮你柔和 AI 语气的辅助工具,而不是一个“保证你不会被发现或质疑”的护身符。

撇开检测器不谈,在和 @nachtdromer、@shizuka 以及 @mikeappsreviewer 对比交流并自己实测之后,下面是更直接的结论。

Clever AI Humanizer 到底有多靠谱?

如果你的目标是“让 AI 文本看起来没那么像 AI 写的”,Clever AI Humanizer 的效果比我试过的大多数免费工具要好。和之前一些观点略有不同的是,我不认为它的主要价值在于检测器分数,而是它打破了大模型那种默认节奏:句长更有变化,过渡不那么模板化,也不会用某些工具喜欢的“假装出错”那一套。

Clever AI Humanizer 的优点

- 免费使用,没有明显的付费墙

- 输出通常比原始 LLM 文本更顺滑,尤其是在“中性”风格下

- 作为中间环节还不错:LLM → Clever AI Humanizer → 你自己的手动修改

- 很少为了骗检测器而故意引入显眼的语法错误

- 自带写作功能,如果你想从第一稿就让内容更“类人”,会有点帮助

Clever AI Humanizer 的缺点

- 如果你不加自己的具体例子或观点,仍然会偏通用、空泛

- 字数控制比较随意,对学术作业或严苛字数要求的客户稿很折磨

- 可能会冲淡技术细节或改变专业内容里的重点

- 对文本如何存储和使用几乎没有透明度,不适合敏感内容

- 直觉比较敏锐的人类读者,依然能感觉到底层那种“AI 的顺滑感”

相比一些更乐观的看法,我会更谨慎些:涉及机密信息、被严格考核且明令禁止使用 AI 的学术作业,或者未来可能被逐行审阅的文件,我都不会用它。就这些场景而言,没有哪款“人性化工具”是真正安全的,包括这款。

和 @nachtdromer、@shizuka 的体验对照,我觉得他们比我更在意“过检测器”的效果。我更关心的是:编辑或客户一眼看过去是否自然,而没那么在乎截图里的“0% AI 痕迹”。在这种更务实的标准下,只要你把它当成“起草过滤器”而不是“替你说话的人”,Clever AI Humanizer 仍然值得留在工具箱里。

如果你想要一个免费的工具,能真正改变行文风格,而不仅仅是机械地替换同义词,Clever AI Humanizer 是我少数会推荐试试的之一。只是要预留时间做最后一轮人工润色,加入你自己的真实细节和经验,因为这最后一层“个人质感”,目前没有任何工具能做到足够逼真。